古息游子(Oliver)

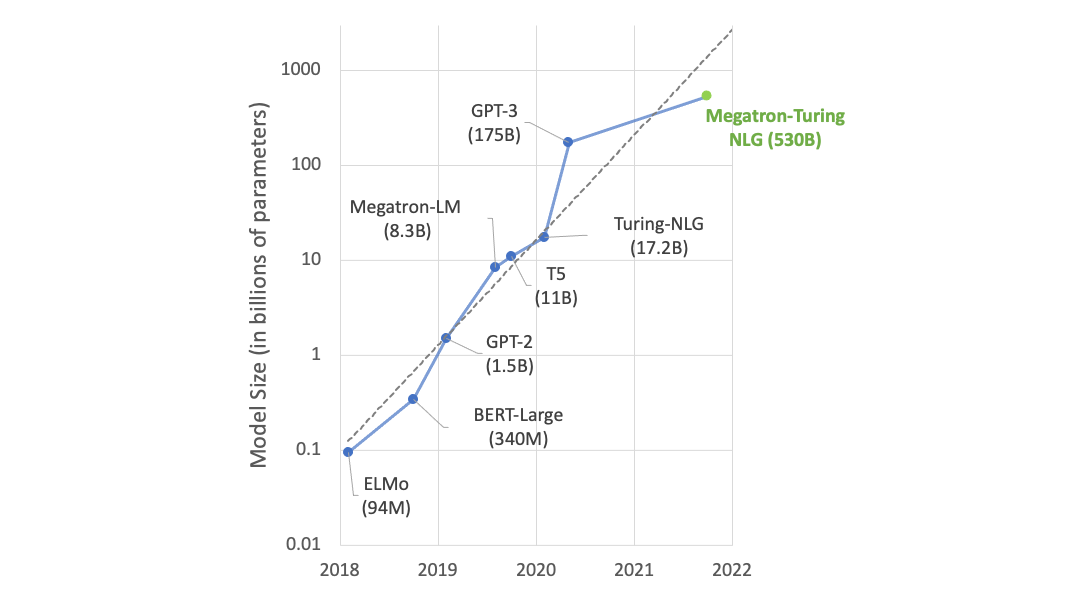

边走边记, 记录风景,记录心情, 记录思考, 记录人生ChatGPT掀起生成AI的大浪潮, OpenAI chatGPT 成为历史上安装速度最快的应用程序.它已经可以通过宾夕法尼亚大学沃顿商学院的考试,也可以打败80%的医生、律师. 伊隆马斯克和一群科学家开始担心人工智能会伤害人类,并呼吁暂时停止开发人工智能. 但没有人能阻止AI的脚步. 上周日,Nvidia CED 黄仁勋在 computex 2023 发表主题演讲,再次引来业界追捧.

黄仁勋说:我们已到达生成式AI引爆点。从此,全世界的每个角落,都会有算力需求。

- 英伟达的GH200 Grace Hopper现已全面投产。超级芯片2000亿个晶体管,提升了4 PetaFIOPS TE、72个通过芯片到芯片链路连接的Arm CPU、96GB HBM3和576 GPU内存。黄仁勋将其描述为世界上第一个具有巨大内存的加速计算处理器:“这是一台计算机,而不是芯片。” 它专为高弹性数据中心应用而设计。

- 如果Grace Hopper的内存不够用,英伟达有解决方案——DGX GH200。 它是通过首先将8个Grace Hoppers与3个NVLINK交换机以900GB传输速度的Pod连接在一起,再将32个这样的组件连接在一起,再加上一层开关,连接总共256个Grace Hopper芯片。 由此产生的 ExaFLOPS Transformer Engine具有144 TB的GPU内存,可用作巨型GPU。黄仁勋说Grace Hopper速度非常快,可以在软件中运行5G堆栈。 谷歌云、Meta和微软将是第一批获得DGX GH200 访问权限的公司,并将对其功能进行研究。

- 英伟达发布了Spectrum-X加速网络平台,以提高基于以太网的云的速度。它包括Spectrum 4交换机,它有128个端口,每秒400GB和每秒51.2TB的传输速度。黄仁勋说,该交换机旨在实现新型以太网,并设计为端到端以进行自适应路由、隔离性能和进行结构内计算。它还包括Bluefield 3 Smart Nic,它连接到Spectrum 4交换机以执行拥塞控制。

- 英伟达发布机器人平台英伟达Isaac ARM现在可供任何想要构建机器人的人使用,并且是全栈的,从芯片到传感器。Isaac ARM从名为 Nova Orin 的芯片开始,是第一个机器人全参考堆栈。

- 在发布会上,黄仁勋还展示了生成式AI以文字形式输入然后输出音频、视频或实时创作音乐并唱出来.

黄仁勋直言在人工智能和加速计算这一未来方向上,GPU服务器有着更为强大的优势。传统上电脑或服务器最重要的 CPU,这个市场主要参与者包括英特尔和AMD。但随着需要大量计算能力的AI应用出现,GPU将成为主角,英伟达主导了当前全球AI GPU 市场。

黄仁勋在演讲上展示的范例,训练一个LLM大语言模型,将需要960个CPU组成的服务器集群,这将耗费大约1000万美元,并消耗11千兆瓦时的电力。相比之下,同样以1000万美元的成本去组建GPU服务器集群,将以仅3.2千兆瓦时的电力消耗,训练44个LLM大模型。

如果同样消耗11千兆瓦时的电量,那么GPU服务器集群能够实现150倍的加速,训练150个LLM大模型,且占地面积更小。而当用户仅仅想训练一个LLM大模型时,则只需要一个40万美元左右,消耗0.13千兆瓦时电力的GPU服务器即可。

换言之,相比CPU服务器,GPU服务器能够以4%的成本和1.2%的电力消耗来训练一个LLM,这将带来巨大的成本节省。

Nvidia 不仅制造 GPU 芯片,它还开发软件平台:CUDA 和 Omniverse。 提供基础模型,提供云计算服务,帮助客户,尤其是小公司建立模型,或将超级计算机租给中小公司客户。

CUDA® 是 NVIDIA 专为图形处理单元 (GPU) 上的通用计算开发的并行计算平台和编程模型。借助 CUDA,开发者能够利用 GPU 的强大性能显著加速计算应用。

在经 GPU 加速的应用中,工作负载的串行部分在 CPU 上运行,且 CPU 已针对单线程性能进行优化,而应用的计算密集型部分则以并行方式在数千个 GPU 核心上运行。使用 CUDA 时,开发者使用主流语言(如 C、C++、Fortran、Python 和 MATLAB)进行编程,并通过扩展程序以几个基本关键字的形式来表示并行性。

NVIDIA 的 CUDA 工具包提供了开发 GPU 加速应用所需的一切。CUDA 工具包中包含多个 GPU 加速库、一个编译器、多种开发工具以及 CUDA 运行环境。CUDA 已经有400万开发者和超过3000个应用程序,CUDA的下载量达到了4000万次,其中仅去年一年就达到了2500万次。通过 CUDA 开发的数千个应用已部署到嵌入式系统、工作站、数据中心和云中的 GPU。

Nvidia 创建的实时 3D 图形协作平台Omniverse,已应用于视觉效果和“数字孪生”工业仿真行业. 大型汽车制造商宝马已经使用 Omniverse 对数字工厂进行实时模拟、监控和控制,大大提高了效率,降低了成本.

Culitho: Nvidia 与 ASML、Synopsys 和 TSMC 合作,开发了 Culitho 软件平台/算法,用于计算光刻,可以将高级掩模流片时间从 2 周缩短到几个小时,功耗降低 3~5 倍。 奠定了2nm节点制程的基础。

英伟达目前占据AI芯片96%以上的市场份额,根据Trend Force预测,到2026年将占据80%的AI芯片市场份额,当然是AI时代的王者/

台媒报道,现在买Nvidia GPU比买海洛因还难. 一颗 Nvidia A100 芯片价格超过 40000 美元.

现在 Nvidia 的市值为 9232 亿美元,距离 1 万亿美元仅一步之遥。 它是历史上第一家达到这一水平的半导体公司。 它的市值是英特尔和AMD总和的3倍