Technical trading

Technical analysis is a way to trade stocks. There are different ways to trade. You get your way that match your personality.Meta 正在走出阴霾。

伴随着 Meta 的股价升至历史新高,这家公司宣布了有史以来的首次股息派发。

最近一次财报电话会议公布内容显示,Meta 公布的 2023 全年营收为 1349 亿美元,较 2022 年增长 16%;净利润为 391 亿美元,同比增长 69%。其中,第四季度营收为 401 亿美元,超出预期的 391.8 亿美元,同比增长 25%。

从 3 月份开始,Meta 将按季度向 A 类和 B 类普通股派发现金股息 50 美分。

根据彭博社汇编的数据,首席执行官扎克伯格持有约 3.5 亿股股票(Meta 13% 的股份),他将从每季度派发的股息中获得约 1.75 亿美元的税前收入,一年下来约有 7 亿美元。

小扎表示:「随着社区和业务持续增长,我们度过了一个不错的季度。」

虽然这家公司在 2022 年经历了市值的低谷,但 Meta 股票在过去 12 个月里上涨了 168%。公司市值已重回万亿美元行列,扎克伯格的净资产更是达到了 1420 亿美元。

与其他一些大型科技公司的创始人不同,扎克伯格这位首席执行官从未将权力移交给其他人,并一直在元宇宙和人工智能等趋势上进行长期押注。

过去这段日子,Meta 在人工智能领域的表现毫不逊色:生成式人工智能大语言模型 Llama 可与 OpenAI 和谷歌的模型竞争,Meta 同时在寻求将人工智能工具集成到其核心产品中,据传还计划使用自研芯片为其人工智能系统提供动力。在不久前的一段视频中,扎克伯格暗示了 Meta 开发通用人工智能 (AGI) 的宏伟计划。

在好于预期的业绩之外,这些消息似乎也提振了外界对于 Meta 的信心。看来,Meta 正在走出阴霾。

凭借 Llama,Meta 正在 AI 领域开辟新战场

如果时间回到一年多以前,或许谁也没有想到,曾经深陷元宇宙泥沼的 Meta 能凭借一组开源模型重新扳回一局,甚至在 OpenAI、谷歌主导的 AI 闭源世界之外重新开辟了一个战场。

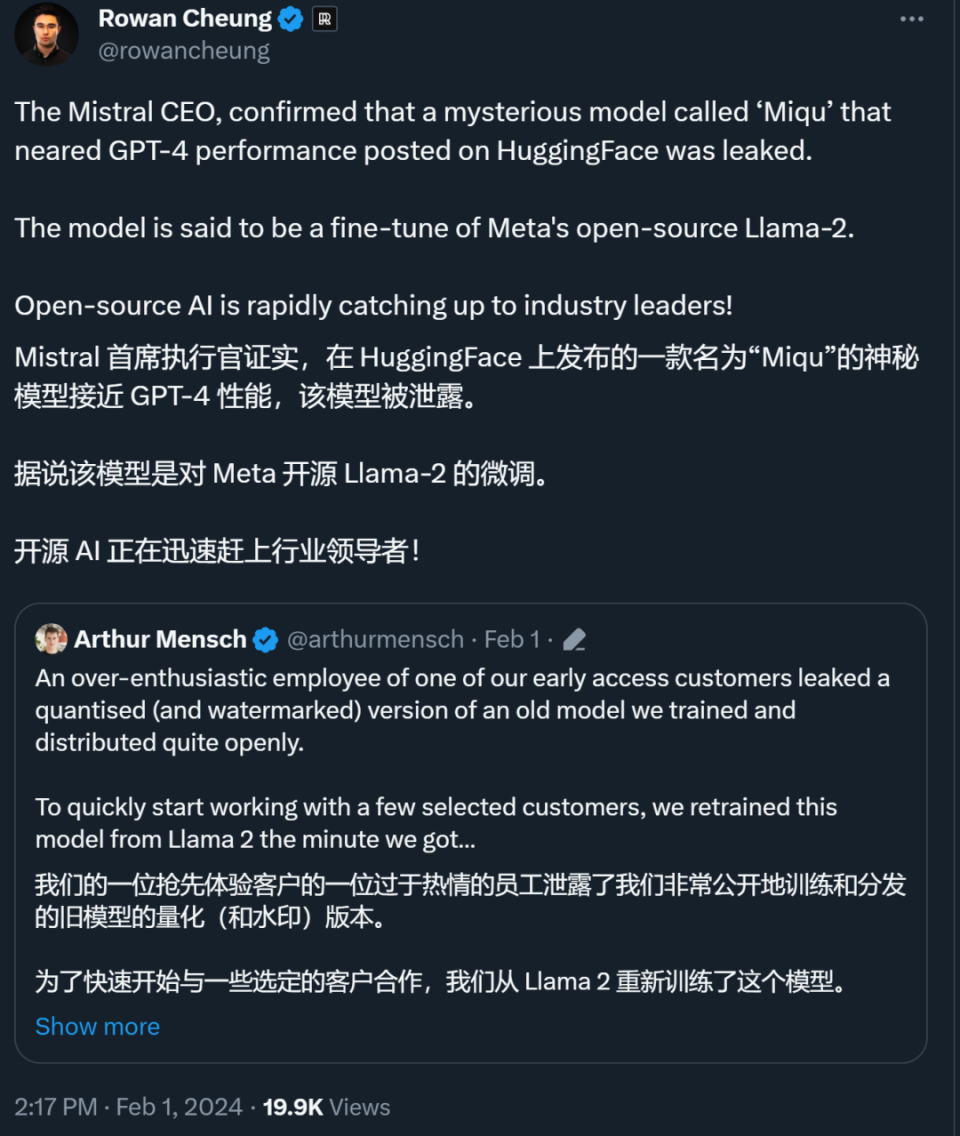

这个战场以 Meta 开源的 Llama 系列模型为基础,成员异常活跃。在其基础上微调的 AI 大模型很多都宣称已经超过 GPT-3.5,甚至已经逼近 GPT-4(比如最近从 Mistral 公司泄露出的「Miqu」模型,该模型接近 GPT-4 性能,是 Mistral 基于 Llama 2 为自家客户训练的早期版本)。

与此同时,Meta 开源模型在业界的影响力也在逐渐显现。很多国际大公司,比如富国银行、IBM,如今都部署了基于 Llama 2 的开源模型。

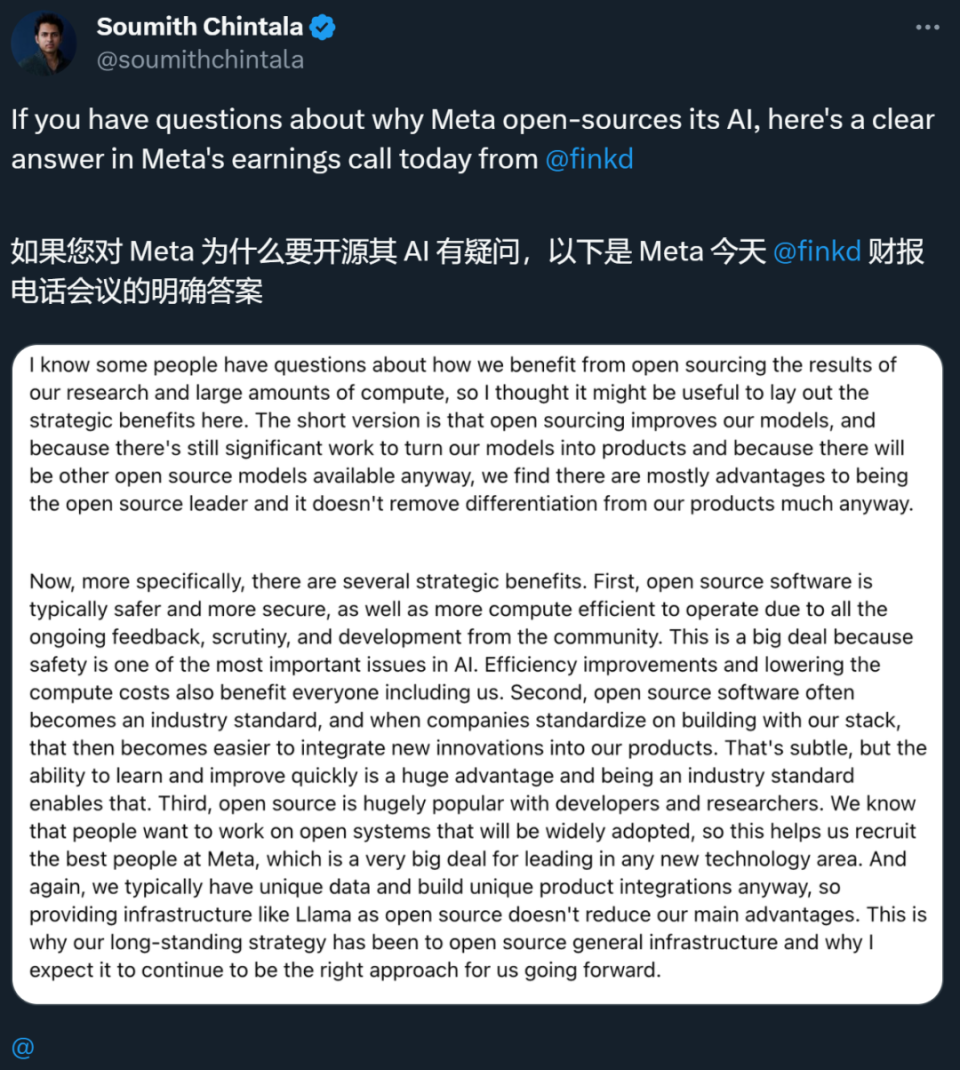

对于为什么选开源路线,Meta 在最近的财报电话会上给出了回应。Meta 坦言,他们确实从开源这条路上收获了很多,包括基础模型的改进和模型到产品的过渡等多个方面。而且,他们认为,成员开源的领导者有几个战略优势:

首先,开源软件通常更安全、更可靠,同时由于社区的持续反馈、审查和开发,运行效率更高。这是一个大问题,因为安全性是人工智能中最重要的问题之一。效率的提高和计算成本的降低也让包括 Meta 在内的每个人都受益。

其次,开源软件通常会成为行业标准。Meta 表示,当其他公司使用 Meta 的技术栈进行标准化构建时,Meta 就能很容易地将其他公司的创新整合到自己的产品中。这很微妙,但是快速学习和改进的能力是一个巨大的优势,并且成为行业标准使得这种做法成为可能。

最后,开源在开发者和研究人员中非常受欢迎,这有助于 Meta 招募到最好的人才。

不过,要让这些效果完全显现可能还要等一段时间,毕竟 Meta 开源系列模型的发布时间要晚于 ChatGPT。

在上个月发布的一个视频中,扎克伯格表示,他们正在全力训练 Llama 3,而且未来会坚持走开源路线。为了训练模型,他们将购买 35 万块英伟达 H100 GPU,而且自研芯片也提上了日程。

为了算力,Meta 也在造芯

据路透社报道,Meta 正在研发一款面向数据中心的定制芯片「Artemis」。

这算是 Meta 内部人工智能芯片项目的一个积极转折,在此之前,Meta 高管曾在 2022 年的公司财务紧缩时期决定停止对自研芯片的投入。

但在去年,Meta 先是公布了自研的第一代训练与推理加速器 MTIA。Artemis 是 Meta 内部芯片生产线的第二代产品,有助于减少 Meta 对英伟达芯片的依赖,同时控制与运行生成式 AI 工作负载相关的成本。

研究机构 SemiAnalysis 创始人 Dylan Patel 表示,按照 Meta 的运营规模,成功部署自己的芯片有可能每年节省数亿美元的能源成本和数十亿美元的芯片采购成本。

运行人工智能应用所需的芯片、基础设施和能源已成为科技公司投资的巨大洼地,在一定程度上抵消了围绕这波技术热潮所带来的收益。

一位 Meta 发言人证实了在 2024 年投产更新芯片的计划,并表示它将与该公司正在购买的数十万个现成的 GPU 协同工作。

发言人的声明中如此表示:「我们认为,我们内部开发的加速器与市面上的 GPU 有很强的互补性,可以在 Meta 特定的工作负载上提供性能和效率的最佳组合。」

或许大家都还记得,小扎前不久发布过一段短视频,曾表示公司计划在 2024 年底前从英伟达采购大约 35 万台旗舰 H100 处理器,加上其他供应商,Meta 将总共拥有相当于 60 万个 H100 的计算能力。

过去几年,生成式 AI 的兴起某种程度上得益于英伟达先进的 GPU。反过来,由于供不应求,H100 变得备受追捧且极其昂贵,使英伟达首次跻身万亿美元市值公司的行列。

这种态势还促使微软、Meta、OpenAI、亚马逊和谷歌等科技巨头开始开发自己的 AI 处理器。与此同时,英伟达、AMD 和英特尔等芯片制造商也陷入了军备竞赛,以发布更新、更高效、更强大的芯片。

随着生成式 AI 服务需求的持续增长,芯片显然将成为科技公司的下一个重点战场。

在开源 AI 大模型上的突飞猛进,加上算力等方面的积极动作,Meta 在科技圈的形象正在重塑。当然,在 2024 年的竞争中,Meta 也将迎来更加严酷的考验。你看好这家公司吗?